Kan botar ha känslor?

Varför inte? Absolut. Men hur tänker jag då?

Logiskt sett finns det ju egentligen bara två möjliga svar på frågan: ”ja” och ”nej”. Betydligt mer framstående personer på området än jag är splittrade i frågan. Vägdelaren är ofta vår syn på oss själva: Är vi en biologisk maskin och vårt medvetande bara en produkt av de fysiska processer vi har i den, eller är det så att intelligens uppstår någon annanstans, ungefär som att en myrstack till synes kan fatta intelligenta beslut om var den ska placeras eller att laga sig själv, trots att ingen enskild myra faktiskt fattar beslut om det. Det finns spännande böcker att läsa på ämnet, men min syn är att vi närmar oss problemet från en alldeles för komplex synvinkel. Det är helt enkelt fel fråga vi försöker svara på.

Den allmänna debatten är fokuserad runt idén att en superintelligent dator ska härma mänsklig intelligens och replikera mänskliga förmågor. Jag är primärt inte intresserad av vad vi kommer kunna göra i en framtid, eller hur vi ska kunna skapa en artificiell hjärna med övermänsklig kapacitet, utan vad vi kan arbeta på nu. Vad är relevant för de program vi bygger idag? Vad specifikt kan eller borde vi göra med de botar vi bygger nu? Hur gör vi för att få våra system att vara empatiska? Så småningom kanske vi bygger en maskin som får en fysisk upplevelse av sina känslor, men är det inte mer intressant att se vad vi kan åstadkomma här och nu? För verktyg finns för att såväl upptäcka som visa känslor, skulle jag vilja påstå.

Är det äkta känslor?

Det kanske även är en poäng att resonera om vad känslor är och hur de fungerar – just i perspektivet av vad vi ska göra med en bot. Känslor hjälper oss att slippa analysera mängder av inkommande data för att snabbt komma till ett beslut. Ett exempel som ofta används i det här sammanhanget är att människor som analyserade huruvida ett lejon var farligt eller inte, hade en lägre överlevnadsfrekvens, vilket i praktiken innebar att känslostyrning var en mer effektiv strategi än den mer långsamma och kanske mer exakta analysen.

Känslor för oss människor är ju mer av ett filter som alla våra beslut passerar igenom och som minimerar effektuttaget i hjärnan till nivåer som vi klarar att hantera. Känslor och intuition är i någon mening en nödvändig resursbesparing. Jag antar att det är en nödvändighet för att kunna driva en processor som hjärnan med sina 100 miljoner neuroner och en triljon synapser på ca 20 watt. Hjärnan måste också kunna filter den enorma mängd information som den uppfattar via våra sinnen – detektorerna till omvärlden.

Vi har inte alls dessa begränsningar att ta hänsyn till när vi bygger artificiell intelligens, eftersom vi inte bygger dessa lösningar för att hantera all variation en människas liv består av, utan för att hjälpa till med en konkret uppgift. Vi kan istället noga överväga vilka detektorer till omvärlden vår artificiella intelligens kan behöva och i vilka sammanhang. Vi bygger helt enkelt inte en allmän artificiell intelligens, och då blir uppgiften väsentligt lättare. Då behövs inte heller så mycket av de mekanismer som hjärnan har för att försäkra sig om att den fokuserar på rätt sak. Vi är helt enkelt inte på nivån där vi behöver triljoner synapser. Känslor i det sammanhanget blir mindre av en strategi gör att hinna filtrera rätt information, och mer ett verktyg för mer effektiv kommunikation.

Sen kommer en bot inte ha en fysisk upplevelse av känslan – om vi inte bygger in den, förstås – men det behöver vi ju inte. För de syften vi har idag, räcker det att boten uppfattar en känsla och reagerar på den. Att reaktionen inte är fysisk, tycker jag inte spelar någon roll. Den fysiska upplevelsen är ju förknippad med en fysisk kropp. I en virtuell kropp, får rimligen även känslor en virtuell motsvarighet. Boten har då – ur perspektivet vad dess medvetande är, inga som helst problem att uppfatta en känsla.

Medvetande då?

Man kan ju inte ha känslor utan medvetande. Därför är en fråga som tas upp i de här sammanhangen huruvida vi skapar ett medvetande hos våra datorprogram. När vi diskuterar maskiners medvetande, gör vi det ofta ur ett teoretiskt och filosofiskt perspektiv, där vi funderar på om vi kan göra en dator lika medvetna som oss själva.

Medvetande-diskussionen är visserligen central om man vill skapa generell artificiell intelligens, men ur ett bot-perspektiv skulle jag vilja påstå att det är ointressant. En hjärna har så många fler neuroner och synapser än en dator har transistorer, att jämförelsen blir irrelevant. Vårt medvetande är till för att hantera vår omvärld. En bots medvetande är till för att hantera sin uppgift. Jag skulle därför även här vilja vända på frågan. Poängen för en bot som är inte medvetenhet på mänsklig nivå, utan snarare en medvetenhet om var i sin värld den befinner sig.

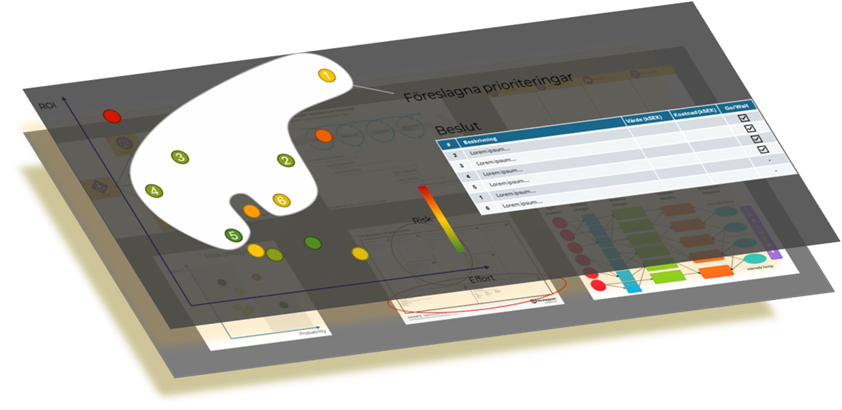

För mig är en bots medvetande förmågan att uppfatta och reagera på sin omgivning utifrån sin världsbild, precis som vårt medvetande är vår förmåga att förstå och reagera på vår omgivning utifrån vår. Jag brukar därför prata om botens medvetande som de dialoger den kan hantera. Om du tänker dig en bots dialog som en mindmap, där varje replikskifte är en bubbla och de streck som går ut ur bubblan de möjligheter vi byggt för den att ta, beroende på hur dialogen utvecklas, så är denna mindmap hela dess värld. Och i den världen är den högst medveten om var den befinner sig. Om vi i modellen med mindmap-bubblor inkluderar att fånga och förstå känslor, ja, då kan en bot kan känslor.

Det är inte längre en fråga om huruvida en dator är medveten,

utan snarare hur medveten den är.

Självklart skapar vi inte en dator som är medveten om vår omvärld när vi bygger en bot, men inom ramen för dess egen värld, alltså sina ”pratbubblor” i sin mindmap, skulle jag vilja påstå att den är medveten. Den förstår exakt det den är byggd för, men inget annat – egentligen precis som vi. För precis som datorer, har vi ju begränsningar i vårt medvetande. Hundar hör till exempel – och är ibland smärtsamt medvetna om – högfrekvent ljud. Fåglar har teckningar i fjäderdräkten som bara syns i ultraviolett ljus, och såvitt vi förstår är de medvetna om dessa. Vi är dock lyckligt omedvetna om båda. Trots det ser vi oss själva som ytterst medvetna om vår omgivning. Precis på samma sätt påstår jag att en bot medveten om det som är dess värld – i den utsträckning vi väljer att göra den det. I takt med att den världen expanderas, expanderas också dess medvetande.

Det innebär självklart inte att en bot har samma ”rika” upplevelse av omvärlden som vi har, men det innebär att den vet var i sin värld den befinner sig och hur den ska reagera på det vi ber den om. Det är upp till oss som skapar den att göra reaktionerna mer finmaskiga och nyanserade. Så småningom kanske lika nyanserad som en människa, men för oss här och nu är det som sagt mindre relevant. Vi kan bygga boten så medveten vi kan och göra upplevelsen av att prata med en bot bra därför att vi tänkt på det från början. Vi kan helt enkelt se till att boten kommer ihåg sitt sammanhang och agerar därefter. Och precis som en människa kan vi se till att den reagerar olika beroende på vad vi säger till den. På det viset blir inte medvetande något mystiskt som skapats ur etern mellan de biologiska processer som pågår i våra huvuden, utan något vi kan bygga ut i takt med vår förmåga och våra behov.

Hur känslig ska en bot vara?

Men det finns ytterligare ett perspektiv på frågan:

Vi inte bara kan bygga botar som har känslor, vi måste.

Botar är till för att samtala med oss. Vad föredrar vi att tala med? En kall oempatisk maskin eller en inkännande personlighet som gör sitt bästa för att förstå vad vi vill och känner? Visserligen vill vi inte att botar ska vara koleriska eller osakliga, men det är ju att ta det hela till den andra extremen. Jag tror att våra förväntningar på en bot är att den ska vara saklig och veta vad den pratar om, och också vara inkännande och prioritera våra behov – eller för att säga samma sak med mer mjuka ord: att den ska bry sig oss. Det är vad brainless vision handlar om och vad vi vill tillföra till bot-byggande.

Som jag sade i början på det här blogginlägget, kan man hävda att vi använder vi känslor för att förenkla våra beslut och för att ge nyans till vår upplevelse. Känslor är ett filter genom vilket fakta filtreras. Det hävdas ju till och med att vi fattar alla våra beslut på känsla och att logik är en mental efterkonstruktion, en förklaring för oss själva varför vi gör det vi gör. När evolutionen byggde vår hjärna för överlevnad på savannen, där vårt biologiska ursprung blev format genom att ineffektiva beslutsfattare blev uppätna, fick vi på köpet hela upplevelsen av vår omvärld och en hel del faktaförvanskning. Känslor är vårt interface till omvärlden, och om vi anpassar våra botar till det, blir de så mycket bättre.

En bot filtrerar och förvanskar också verkligheten, där dess begränsade förmåga att se sin omvärld skapar den bild vi gett den av omvärlden, och de egenskaper vi tror att den behöver för att klara sitt jobb. Men det är inte poängen. Vi vet redan att det är en maskin. Boten behöver inte känslor för att snabbt komma till rätt beslut – så komplicerad är helt enkelt inte dess värld. Den logik som boten följer är så enkel att den klarar av att ta hänsyn till allt den vet utan att vi upplever att det störande. Känslor för en bot handlar därför bara om att visa att den förstått personen den talar med. Beroende på hur personen svarar, kan boten, precis som en människa, reagera annorlunda.

|

Vad har vi då för komponenter till vårt förfogande? Vi kan uppfatta tonen i en användares interaktion och vi kan välja att agera på den. Om vi ger boten förmåga att reagera olika på olika tilltal, ser till att den agerar på det, och svarar efter hur den uppfattar personen som talar till den, då visar den ju upp känslor. Har den en fysisk känsla inombords? Nej, självklart inte, men för dig och mig, som pratar med den så kommer det att verka så. En bot är inte en så komplex konstruktion så den behöver genvägen av en känsla. Å andra sidan är det inget som hindrar att vi i dess medvetande – tänk mindmap:en igen – har en lite låda som vi kallar glad, en annan vi kallar ledsen, och så vidare. De här lådorna kan vi ge poäng till löpande under konversationen. Om sedan boten tittar i lådan och konstaterar att den är full, känner den då något? Boten saknar visserligen fysisk förmåga att förnimma känslorna, men gör följande lilla tankeexperiment: Låt oss stanna vid att vi försöker ge boten en känsla. Lycka. Vi gör det genom att i programmet lagra ett värde på lycka mellan 0 och 100. Om boten läser värdet, är det ett sämre sätt att uppleva lycka? Även om boten saknar den fysiska upplevelsen, vet den att den är lycklig. Det står ju i parametern. I sin enkla modell av verkligheten kan jag tycka att det är bra nog. Den fysiska känsla vi har skulle vi mycket väl kunna återskapa, när vi väl bygger en mer komplicerad maskin. I det läget är det ju bara att låta maskinen dra ihop magmusklerna när den blir rädd, och ha en sensor som känner muskelspänningen.

Just nu kan vi överlåta det åt Hollywood. Idag bygger vi enkla digitala maskiner som klarar enkla uppgifter. Då kan även sättet den känner igen en känsla vara enkel. För återigen skulle jag vilja påstå att det viktiga är vad vi kan göra här och nu. Vi kan bygga våra botar så att de reagerar och agerar på våra känslor. Det gör att vår upplevelse blir annorlunda. Bygger vi en grinig bot, så kommer den att uppfattas som grinig. Bygger vi en inkännande bot kommer den uppfattas som inkännande. Men det är inte min poäng. Min poäng att vi kan få den att uppfatta att den är lycklig, och bete sig som att den är det. Det beteendet kan vi omforma till bättre service till dig. För inte spelar det oss någon roll hur en bot känner det den känner? Det viktiga är väl att den känner vad vi känner och hjälper oss med det vi vill ha hjälp med.

En empatisk bot.

En brainless #brobot.

2019-04-30 14:39

Comments